Avant-propos

Pour ce billet, je vais essayer quelque chose de nouveau en y introduisant une touche de sémantique. Ainsi, les passages strictement scientifiques seront en gras, mes remarques personnelles en italique (à lire à la manière d'apartés), et le reste en normal. Naturellement, des combinaisons sont possibles : je peux très bien faire une remarque scientifique en gras et italique.

De cette façon, les personnes voulant aller droit au but pourront juste se contenter de lire les parties qui les intéressent, alors que celles prenant un café auront le temps de le terminer en considérant mes bafouilles :)

Le déplacement

Armé de ma profonde non-maîtrise de la langue espagnole (pour tout vous dire, mon espagnol est encore plus mauvais que mon néerlandais, et je n'arrive à parler néerlandais que lorsque je suis totalement ivre; c'est dire le niveau), j'ai donc débarqué à l'aéroport de Barcelone. Aéroport qui, naturellement, ne porte le nom de Barcelone que par un surprenant hasard vu la distance qui sépare ces deux endroits…

Armé de ma profonde non-maîtrise de la langue espagnole (pour tout vous dire, mon espagnol est encore plus mauvais que mon néerlandais, et je n'arrive à parler néerlandais que lorsque je suis totalement ivre; c'est dire le niveau), j'ai donc débarqué à l'aéroport de Barcelone. Aéroport qui, naturellement, ne porte le nom de Barcelone que par un surprenant hasard vu la distance qui sépare ces deux endroits…

Honnêtement, Barcelone est une ville superbe : des vieux quartiers, des œuvres d'art moderne un peu partout, des immeubles au style design… En plus, il y fait beau et chaud, mais pas trop. La mer est juste aux pieds de la ville, et surtout le nombre de palmiers au mètre carré est limite indécent. Je vous le dis, moi : il faut relocaliser SILEX à Barcelone :)

Honnêtement, Barcelone est une ville superbe : des vieux quartiers, des œuvres d'art moderne un peu partout, des immeubles au style design… En plus, il y fait beau et chaud, mais pas trop. La mer est juste aux pieds de la ville, et surtout le nombre de palmiers au mètre carré est limite indécent. Je vous le dis, moi : il faut relocaliser SILEX à Barcelone :)

La conférence

Il s’agissait de la première édition de la conférence, ce qui expliquait son flottement sur le papier. En revanche, une fois sur place tout était clair.

J’ai donc assisté aux présentations qui nous intéressent dans SILEX; deux thèmes se sont dégagés :

J’ai donc assisté aux présentations qui nous intéressent dans SILEX; deux thèmes se sont dégagés :

- réseaux sociaux : interconnections, services web, exploitation, analyse nœuds forts, critiques, etc)

- e-learning :

- en s'appuyant sur les plates-formes sociales

- s'appuyer sur Wikipédia (récupérer automatiquement des groupes de ressources liées au thème)

Globalement, la conférence avait un niveau moyen, mais correct. Les thématiques flottaient un peu, mais les organisateurs ont maintenant une vision plus claire de ce qu'ils veulent faire. Pour moi, le principal intérêt de cette conférence était de discuter avec les espagnols qu’on ne voit habituellement quasiment jamais en France.

Comment reconnaître un espagnol dans une soirée ? C'est celui qui parle le plus fort. Comment savoir qu'on est à une conférence espagnole ? Tout les locaux parlent fort !

Il y avait beaucoup, beaucoup, mais alors beaucoup d'asiatiques (chinois, japonais, thaïlandais); ils sont partout désormais ! Ce qui les intéresse surtout :

- télécom, surtout mobilité

- e-learning :

- langue (anglais oral, pour conversation)

- reprise individuelle des cours d'un professeur (rejouer les annotations et schémas du prof au lieu d'avoir juste le résultat statique)

L’authentification biométrique, c'est un peu la loose quand ça ne fonctionne pas, surtout en plein écran sur le vidéo projecteur : être logué en dehors de sa machine car on a les doigts gras, c'est pas lol du tout :) Bref, les chinois ont pleins de gadgets sympa dans les poches, mais la qualité est… chinoise, on dira.

Travaux intéressants vus sur place

Je n’ai rien vu qu’y ait spécialement retenu mon attention, mais j’ai malgré tout noté quelques petites choses qui m’ont titillé.

Poster « Group Intelligence: a distributed cognition perspective » : vision du web 2 selon un point de vue de cognition distribuée.

Poster « Group Intelligence: a distributed cognition perspective » : vision du web 2 selon un point de vue de cognition distribuée.

Poster « Social Educational Games based on Open Content » : le but de leurs travaux est, entre autre, d'arriver à mettre en place un système d'e-learning ludique construit automatiquement à partir de ressources libres; ça peut être des jeux de questions-réponses, de coloriage de cartes, etc. J'aime bien l'idée, mais je n'en sais pas suffisamment sur leurs approches pour dire ce que ça vaut.

Poster « Social Educational Games based on Open Content » : le but de leurs travaux est, entre autre, d'arriver à mettre en place un système d'e-learning ludique construit automatiquement à partir de ressources libres; ça peut être des jeux de questions-réponses, de coloriage de cartes, etc. J'aime bien l'idée, mais je n'en sais pas suffisamment sur leurs approches pour dire ce que ça vaut.

Miloš Kovačević, un serbe, qui travaille sur la création automatique de moteurs de recherche spécialisés à partir d'une simple liste d'URL. Par exemple, on lui fourni une collection de liens pointant vers des ressources choisies par un enseignant pour documenter son cours, et l'outil va construire automatiquement un corpus étendu à partir des liens hypertextes initiaux, pour ensuite alimenter un moteur de recherche; du coup, avec juste quelques liens on se retrouve avec un vaste ensemble de documents. Il cherche à améliorer son travail en collectant automatiquement des ressources jugées pertinentes, en se basant sur la navigation de l'utilisateur, ses échanges avec d'autres personnes, etc. Donc, hop des traces.

Ma présentation

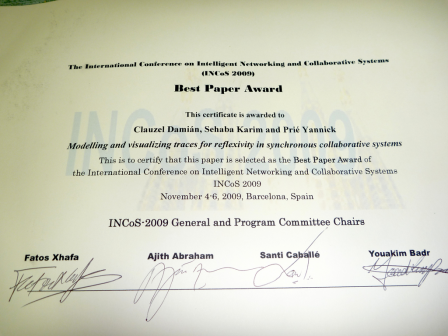

Passant en dernier, j’avais décidé de réveiller la salle en dynamisant un peu la présentation; pas de doute, ça a marché : c'est moi qui ai distribué le plus de cartes de visite dans le panel (bon, OK, les traces modélisées ont intéressées les gens bossant sur la collaboration et l'apprentissage; mais quand même). Un des participants du panel n’étant pas présent, j’ai pu (discrètement :) récupérer son temps de parole pour continuer à discuter sur les traces.

D'ailleurs, le LIRIS devrait vraiment donner des cartes de visite aux doctorants, car là j'ai lâché mes cartes pro à moi, et pas celles aux couleurs du labo… (mais je ne me plains pas, hein ;)

Retours et questions

Expliqué simplement, avec moult dessins et pas de choses qui font peur, le concept de la trace modélisée est facilement compris; surtout en l'appuyant dès le début avec des exemples concrets. Les questions ont porté sur :

- la possibilité de raisonnement à partir des traces : j'ai tracé en deux lignes le RàPET

- la nature du modèle : j'en parlais beaucoup mais n'en montrais jamais concrètement. J'ai commencé par sortir un bout de RDF, mais comme j'ai senti que ça ne passait pas j'ai repris ma métaphore de la boîte à chaussure et du catalogue; et là c'était bon.

- l'utilisation des traces pour fournir à une classe d'élèves des information sur leur travail, leur activité, etc. Comme je ne sais pas vraiment ce qui se fait dans l'équipe en terme de traces dans les EIAH, j'ai renvoyé vers le site de SILEX.

- les gens du e-learning sont d'accord avec le fait qu'on ne peut pas se passer de l'intention et de l'objectif quand on travaille avec des traces modélisées pour l'humain

- quid de l'utilisations des traces passées ? J'ai déroulé l'exemple de KM à base d'insertion d'image dans Word (très très bien cet exemple pour faire comprendre aux gens l'utilisation de traces)

- est-ce qu'on n'a pas peur de rater des informations sur l'utilisateur dans son activité ? J'ai répondu que dans notre cas de l'apprentissage collaboratif synchrone, cela est très peu probable car on construit le modèle en fonction de l'objectif, de l'activité réalisé et des ressources impliquées. Mais c'est à voir dans d'autres circonstances; rapide évocation de la génération automatique de modèle

Beaucoup de questions, donc, aussi bien théoriques que très pratiques : comment construit-on un modèle ? Quelles sont les possibilités de liaisons avec des outils existants ? Comment exploiter les traces pour faire telle ou telle chose ? Ce qui est régulièrement revenu est la question de faire des inférences automatiques sur les traces, pour produire des nouvelles choses.

Et maintenant ?

Que faire pour exploiter les retours de cette conférence ? Très simplement, il me vient immédiatement à l’esprit qu’il faut :

- une page web de vulgarisation pour présenter les traces

- une courte liste de nos principales publications pour la compréhension des traces

- renforcer la communication au sein de l'équipe (mais je l'ai déjà dit ça, non ? :)

- renforcer le travail en commun au sein de l'équipe

On peut également songer à faire une base de connaissance pour nos déplacements : hôtels où descendre, pièges à éviter, etc. Par exemple :

Barcelone

Hôtel :

- Pension 45, juste à côté de la Placa de Catalunya; fortes connexions pour les transports en commun

- confort simple, tranquille, le wifi gratuit est bon quand il n'est pas saturé par une andouille qui pompe des torrents

Aéroport :

- les navettes avec Barcelone se trouvent au Terminal 1, et se nomment « aérobus »; 5 euros le trajet, des billets A/R existent; vont jusqu'à la Placa de Catalunya

- difficile de trouver des prises de courant dans le Sky Center; il faut les chercher au pied des blocs élévateurs

Transport :

- le ticket à l'unité est cher

- il existe un ticket donnant droit à 10 trajets, pour pas cher du tout

- les portillons du métro sont fourbes : selon le dispositif, soit il faut passer à gauche de la borne, soit il faut passer à droite

Vie quotidienne :

- on survit très bien avec juste quelques mots de vocabulaire, et une langue bien pendue

- les barcelonaises sont faciles à aborder et aident volontiers les touristes

Les documents

J'ai mis, comme d'habitude, mes documents sur SlideShare. Voici les widgets embarqués dans le billet.